Le 20 août, Elon Musk et 115 autres spécialistes de l’intelligence artificielle ont interpelé l’ONU dans une lettre ouverte. Ils alertent sur les dangers des « armes autonomes » capables de frapper sans intervention humaine. Oubliez la science-fiction, la course aux « robots tueurs » est déjà lancée.

Y a-t-il un pilote dans l’avion ?

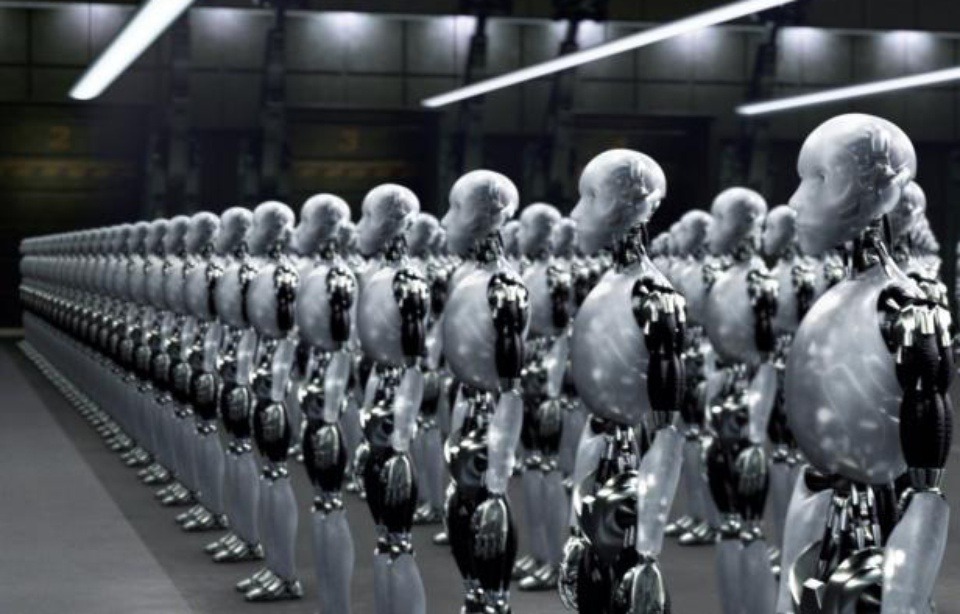

Justement, non. Un robot tueur est une arme autonome dotée d’Intelligence Artificielle (IA). Contrairement au simple drone contrôlé à distance par un individu, le robot tueur décide seul d’attaquer une cible. L’industrie de l’armement en a fait sa nouvelle lubie. Arguments phares : augmenter la précision des tirs et épargner la vie de soldats en les remplaçant par des automates.

En Israël par exemple, la dernière création de General Robotics se nomme Dogo. Ce char métallique de 14 cm pour 12 kg peut tirer avec un pistolet, envoyer des gaz lacrymogènes et des grenades aveuglantes comme un grand. Sans aucun contrôle humain.

Dogo, le robot tueur Crédits – humanoides.fr

Un triple-enjeu éthique, juridique et sécuritaire nourrit la controverse. Elon Musk, directeur de SpaceX et Tesla, rejoints par une centaine de PDG d’entreprises leaders dans l’IA et la robotique s’estiment « responsables » de mettre en garde le public contre ces dangers. Ils tirent le signal d’alarme dans cette lettre publiée par The Future of Life Institute.

« Nous n’avons pas beaucoup de temps pour agir. Une fois ouverte cette boîte de Pandore, elle sera difficile à refermer (…) C’est pourquoi nous implorons (l’ONU) de trouver le moyen de nous protéger de ces dangers. »

« Déléguer la décision de vie ou de mort est inacceptable »

Remplacer les soldats par des robots, l’idée est séduisante. Mais dirigé par un algorithme, l’automate n’a qu’un seul objectif : remplir sa mission au plus vite. Quitte à ne rien épargner sur son passage. Il n’est pas en capacité d’interpréter certains détails qui permettent de distinguer les combattants des civils ou des soldats blessés. Pour Bonny Docherty, chercheuse de la division armes de Human Rights Watch « Déléguer la décision de vie ou de mort est inacceptable » Elle soutient que l’empathie humaine demeure essentielle dans le domaine militaire.

« Personne ne pourra être tenu légalement responsable de leurs actions »

En cas de dommages collatéraux, aucun texte de loi n’est prévu, ajoute-t-elle. Qui tenir pour responsable lorsque seul le robot est aux manettes ?

Crédits – AFP Photo – Carl Court –

Manifestation contre les robots à Londres, avril 2013

« Des armes que des despotes et des terroristes pourraient utiliser contre des populations innocentes. »

Une fois lancée, la course à l’armement est très difficile à arrêter. La prolifération des armes nucléaires le prouve. Les robots tueurs peuvent tomber entre de mauvaises mains à l’image de la Corée du Nord qui a aujourd’hui rattrapé son retard nucléaire. Dans un contexte de menace terroriste, les experts prédisent le risque qu’ils se transforment en « armes de terreur, que des despotes et des terroristes pourraient utiliser contre des populations innocentes. » Les armes autonomes peuvent aussi être victimes d’un danger inédit 2.0. Et si le robot tueur se faisait hacker lors d’une mission ?

Les robots tueurs tués dans le nid ?

En réaction à cette triple-menace, certains exigent leur interdiction complète. C’est le cas de l’ONG Human Rights Watch, co-fondatrice de la « Campagne pour stopper les robots tueurs ». Elle a publié un rapport lundi 11 avril 2016 dénonçant la course à l’armement et les dangers impliqués. Une douzaine d’Etats travaillent sur ce projet dont les Etats-Unis, la Russie, la Chine ou encore le Royaume-Uni.

D’autres estiment qu’il est impossible d’interdire ces innovations. Une régulation stricte apparait dès lors comme la meilleure solution. Mais comme pour la menace nucléaire, cela risque d’être un fail. Les traités ne s’appliquent qu’aux Etats daignant s’y soumettre. Et les risques de piratage ou d’utilisation par des organisations terroristes subsistent.

Crédits – REUTERS/Kim Kyung-Hoon Robot géant « Kuratas », exposé à Tokyo en 2012

La prochaine guerre sera-t-elle menée par des armées de robots tueurs ?

L’arme autonome fait figure de troll, ce petit être qui sème la pagaille et énerve tout le monde sur les réseaux sociaux. Elon Musk et consorts craignent cette perte de contrôle. Ils décrivent un art de la guerre en pleine mutation.

« Les armes léthales autonomes permettront des conflits armés à une échelle jamais vue auparavant et à des vitesses dépassant l’entendement humain. »

Stephen Hawking a déclaré que l’IA pouvait « dépasser l’humanité », et « mettre fin à la race humaine » dans un entretien accordé sur BBC 4 en décembre 2014. Pour le célèbre physicien, seule « une forme de gouvernement mondial » pourrait contrôler le développement de sa puissance.

Tandis que les pertes potentielles de vies humaines constituent un facteur de dissuasion de la guerre, les victimes robots n’ont pas le même impact psychologique. Les automates pourraient favoriser le conflit. Le report des débats prévus à partir du 28 août dernier a donné lieu à cette lettre ouverte. Rendez-vous en novembre à l’ONU pour débattre de cette armée de robots tueurs.